Attention: cette page est une traduction automatique (machine), en cas de doute, veuillez vous reporter au document anglais original. Nous nous excusons pour la gêne occasionnée.

Gazer ouvert

Open Gazer Review

- Nom de la technologie: Gazer ouvert

- Lien: http://www.inference.phy.cam.ac.uk/opengazer/

- Prix: libre

- Popularité: NA

- Exigences physiques minimales: Le patient doit pouvoir bouger sa tête librement.

Description détaillée:

Opengazer est une application libre qui utilise une webcam ordinaire pour estimer la direction de votre regard. Ces informations peuvent ensuite être transmises à d'autres applications. Par exemple, utilisé avec Dasher, opengazer vous permet d’écrire avec vos yeux. Opengazer vise à être une alternative logicielle peu coûteuse aux trackers oculaires basés sur du matériel.

La première version d'Opengazer a été développée par PiotrZieliński, avec le soutien de Samsung et de la Gatsby Charitable Foundation. Plus de détails sur cette version peuvent être trouvés.

La recherche pour Opengazer a été relancée par Emli-Mari Nel et est maintenant soutenue par la Commission européenne dans le cadre du projet AEGIS et de la Gatsby Charitable Foundation.

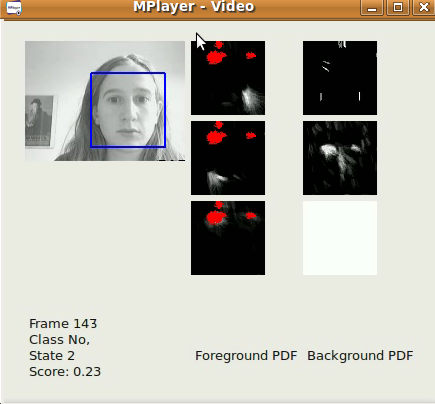

La version précédente d'Opengazer est très sensible aux variations de mouvement de la tête. Pour remédier à ce problème, nous nous concentrons actuellement sur des algorithmes de suivi de la tête pour corriger les variations de la position de la tête avant d'inférer les positions du regard. Tous les logiciels sont écrits en C ++ et en Python. Un exemple de vidéo d'un de nos algorithmes de suivi de la tête peut être téléchargé [ici]. Sous Windows, la vidéo peut être visionnée avec le lecteur VLC. Sous Linux, il est préférable d’afficher Mplayer Movie Player.

La première version de notre algorithme de suivi de la tête est élémentaire, basée sur le détecteur de visage Viola-Jones, qui localise le plus grand visage du flux vidéo (capturé à partir d’un fichier / d’une caméra) aussi rapidement que possible, sur une image image par image. base du cadre. Les coordonnées xy du suivi peuvent déjà être utilisées pour taper avec Dasher. Cela peut être fait en mode 1D (par exemple, en suivant uniquement les coordonnées y) ou en mode 2D. Bien que de meilleurs résultats puissent être attendus après la sortie de notre logiciel de pose de tête, ce logiciel est déjà utile pour la localisation rapide de visages. Notre algorithme applique un simple filtre passe-bas autorégressif sur les coordonnées xy et l'échelle des résultats de détection du détecteur de visage Viola-Jones, et limite également la région d'intérêt d'une image à l'autre. Les paramètres de détection ont été déterminés en fonction de notre application spécifique (c’est-à-dire un seul utilisateur travaillant sur son ordinateur de bureau / ordinateur portable). L'algorithme fonctionne mieux avec des images 320x240, à une cadence de 30 fps et dans des conditions d'éclairage raisonnables.

Un sous-projet d'Opengazer implique la détection automatique des gestes du visage pour piloter un programme à base de commutateur. Ce programme comporte une courte phase d'apprentissage (moins de 30 secondes) pour chaque geste, à la suite de quoi le geste est automatiquement détecté. De nombreux patients (par exemple, des patients atteints de paralysie cérébrale) ont des mouvements de tête involontaires qui peuvent introduire des faux positifs lors de la détection. Nous formons donc également un modèle de base pour traiter les mouvements involontaires. Tous les logiciels sont écrits en C ++ et en Python et seront bientôt disponibles au téléchargement. Un exemple de vidéo de notre algorithme de commutation de geste peut être téléchargé [ici]. Sous Windows, la vidéo peut être visionnée avec le lecteur VLC. Sous Linux, il est préférable d’afficher Mplayer Movie Player. Notez que cette vidéo a du son. Trois gestes ont été formés pour générer trois événements de commutation possibles: un sourire à gauche, un sourire à droite et un mouvement ascendant des sourcils correspondent tous à des événements de commutation. Le modèle d'arrière-plan, dans ce cas, détecte les clignotements, les changements soudains d'éclairage et les mouvements de tête importants. La première sortie officielle aura lieu fin juin 2012.

La première version d'Opengazer comporte le flux de travail suivant:

Sélection des points caractéristiques:

Au démarrage, l'utilisateur doit sélectionner les points de repère sur le visage à l'aide de la souris. Ces points sont suivis dans les étapes suivantes de l'algorithme. Les deux premiers points correspondent aux coins des yeux, qui sont également utilisés dans les étapes suivantes pour extraire les images des yeux. L'utilisateur doit garder la tête très immobile pendant toute la procédure. À ce stade, l'utilisateur doit de préférence enregistrer tous les points de fonction sélectionnés.

Calibrer le système:

Au cours de cette étape, quelques points rouges sont affichés à divers endroits sur l’écran. Les images des yeux sont extraites lors de l'affichage de chaque point. Les images oculaires et leurs positions de points correspondantes sont utilisées pour former un processus gaussien qui représente le mappage entre l'image d'un œil et la position sur l'écran. Notez que les changements de pose de la tête exigent souvent que le système soit recalibré.

Suivi:

Une fois tous les points d'étalonnage traités, le processus gaussien produit une distribution prédictive, de sorte que le point de focalisation attendu de l'œil sur le moniteur d'affichage peut être estimé à partir d'une nouvelle image de l'œil. Si l'utilisateur charge ses points caractéristiques sélectionnés, le détecteur de visage Viola Jones est utilisé une fois pour déterminer la région de recherche dans laquelle les points caractéristiques sont attendus. Par la suite, le flux optique est utilisé pour suivre chaque point caractéristique. Les images oculaires sont extraites (en utilisant les deux premiers coins sélectionnés comme référence) et le regard est prédit à l'aide des images oculaires extraites et du processus gaussien formé.