경고 :이 페이지는 자동 (기계) 번역입니다. 의심이가는 경우 영어 원본 문서를 참조하십시오. 불편을 드려 죄송합니다.

가제트 열기

Gazer 검토 열기

- 기술 이름 : 가제트 열기

- 링크: http://www.inference.phy.cam.ac.uk/opengazer/

- 가격: 비어 있는

- 인기: NA

- 최소 물리적 요구 사항 : 환자는 머리를 자유롭게 움직일 수 있어야합니다.

상세 설명:

Opengazer는 일반적인 웹캠을 사용하여 시선의 방향을 추정하는 오픈 소스 응용 프로그램입니다. 그런 다음이 정보를 다른 응용 프로그램으로 전달할 수 있습니다. 예를 들어, Dasher와 함께 사용되는 opengazer를 사용하면 눈으로 쓸 수 있습니다. Opengazer는 상용 하드웨어 기반의 안구 추적기를 대체하는 저렴한 소프트웨어 대안을 목표로합니다.

Opengazer의 첫 번째 버전은 PiotrZieliński가 개발했으며 Samsung과 Gatsby Charitable Foundation에서 지원합니다. 이 버전에 대한 자세한 내용을 확인할 수 있습니다.

Opengazer에 대한 연구는 Emli-Mari Nel에 의해 부활되었으며, 현재 AEGIS 프로젝트 및 Gatsby Charitable Foundation의 맥락에서 유럽위원회의 지원을받습니다.

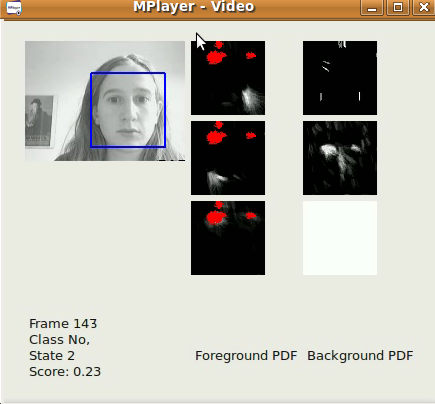

이전 버전의 Opengazer는 헤드 모션 변형에 매우 민감합니다. 이 문제를 해결하기 위해 현재 시선 위치를 유추하기 전에 헤드 포즈 변형을 수정하기 위해 헤드 추적 알고리즘에 중점을두고 있습니다. 모든 소프트웨어는 C ++ 및 Python으로 작성되었습니다. 헤드 트래킹 알고리즘 중 하나의 예제 비디오를 여기에서 다운로드 할 수 있습니다. Windows에서는 비디오를 VLC 플레이어로 볼 수 있습니다. Linux에서는 Mplayer Movie Player를 사용하는 것이 가장 좋습니다.

헤드 트래킹 알고리즘의 첫 번째 버전은 Viola-Jones 얼굴 감지기를 기반으로하는 기본 버전으로, 비디오 스트림에서 가장 큰 얼굴 (파일 / 카메라에서 캡처)을 프레임 단위로 최대한 빠르게 찾습니다. 프레임 기준. 추적의 xy 좌표는 이미 Dasher를 사용하여 입력하는 데 사용할 수 있습니다. 이는 1D 모드 (예 : y 좌표 만 추적) 또는 2D 모드에서 수행 할 수 있습니다. 헤드 포즈 소프트웨어가 출시 된 후 훨씬 더 나은 결과를 기대할 수 있지만이 소프트웨어는 이미 빠른 얼굴 인식에 유용합니다. 이 알고리즘은 xy 좌표에 Viola-Jones 얼굴 탐지기의 탐지 결과 스케일에 간단한 자동 회귀 저역 통과 필터를 적용하고 관심 영역을 프레임마다 제한합니다. 탐지 매개 변수는 특정 응용 프로그램 (즉, 데스크톱 PC / 노트북에서 작업하는 단일 사용자)에 따라 결정되었습니다. 이 알고리즘은 320fps 이미지, 30fps의 프레임 속도 및 적절한 조명 조건에서 가장 잘 작동합니다.

Opengazer의 하위 프로젝트에는 얼굴 제스처를 자동 감지하여 스위치 기반 프로그램을 구동하는 것이 포함됩니다. 이 프로그램에는 각 제스처에 대해 짧은 학습 단계 (30 초 미만)가 있으며 그 후 제스처가 자동으로 감지됩니다. 많은 환자 (예 : 뇌성 마비 환자)는 비자발적 인 머리 움직임이있어 감지 중에 잘못된 긍정을 유발할 수 있습니다. 따라서 우리는 비자발적 움직임을 다루기 위해 배경 모델을 훈련시킵니다. 모든 소프트웨어는 C ++ 및 Python으로 작성되었으며 곧 다운로드 할 수 있습니다. 제스처 스위치 알고리즘의 예제 비디오는 여기에서 다운로드 할 수 있습니다. Windows에서는 비디오를 VLC 플레이어로 볼 수 있습니다. Linux에서는 Mplayer Movie Player를 사용하는 것이 가장 좋습니다. 이 비디오는 소리가납니다. 세 가지 제스처가 세 가지 가능한 스위치 이벤트를 생성하도록 훈련되었습니다. 왼쪽 스마일, 오른쪽 스마일 및 위쪽 눈썹 움직임은 모두 스위치 이벤트에 해당합니다. 이 경우 배경 모델은 깜박임, 급격한 조명 변화 및 큰 머리 움직임을 감지합니다. 첫 번째 공식 릴리스는 2012 년 6 월 말입니다.

Opengazer의 첫 번째 버전은 다음과 같은 워크 플로우를 갖습니다.

특징점 선택 :

시작하는 동안 사용자는 마우스를 사용하여 얼굴의 특징점을 선택해야합니다. 이 포인트는 알고리즘의 후속 단계에서 추적됩니다. 처음 두 점은 눈의 구석에 해당하며 눈 이미지를 추출하는 후속 단계에서도 사용됩니다. 사용자는 전체 절차 중에 머리를 계속 고정시켜야합니다. 이 시점에서 사용자는 선택한 모든 특징점을 저장해야합니다.

시스템 보정 :

이 단계 동안 화면의 여러 위치에 몇 개의 빨간색 점이 표시됩니다. 눈의 이미지는 각 점을 표시하는 동안 추출됩니다. 눈 이미지와 해당 도트 위치는 눈 이미지와 화면 위의 위치 간의 매핑을 나타내는 가우스 프로세스를 학습하는 데 사용됩니다. 헤드 포즈를 변경하면 종종 시스템을 재보 정해야합니다.

추적:

모든 캘리브레이션 도트가 처리 된 후 가우스 프로세스는 예측 분포를 산출하므로, 새로운 눈 이미지가 제공 될 때 디스플레이 모니터에 대한 예상 눈 초점이 추정 될 수 있습니다. 사용자가 선택한 특징점을로드하면 Viola Jones 얼굴 감지기를 한 번 사용하여 특징점이 예상되는 검색 영역을 결정합니다. 이어서, 광학 특징이 각각의 특징점을 추적하기 위해 사용된다. 눈 이미지가 추출되고 (선택된 처음 두 개의 코너 포인트를 기준으로 사용) 추출 된 눈 이미지와 훈련 된 가우시안 프로세스를 사용하여 시선이 예측됩니다.