Achtung: Diese Seite ist eine automatisierte (maschinelle) Übersetzung. Im Zweifelsfall beziehen Sie sich bitte auf das englische Originaldokument. Wir entschuldigen uns für etwaige Unannehmlichkeiten.

Öffne Gazer

Öffnen Sie Gazer Review

- Name der Technologie: Öffne Gazer

- Verknüpfung: http://www.inference.phy.cam.ac.uk/opengazer/

- Preis: kostenlos

- Popularität: NA

- Minimale körperliche Anforderungen: Der Patient muss seinen Kopf frei bewegen können.

Detaillierte Beschreibung:

Opengazer ist eine Open-Source-Anwendung, die eine gewöhnliche Webcam verwendet, um die Blickrichtung zu bestimmen. Diese Informationen können dann an andere Anwendungen weitergegeben werden. In Verbindung mit Dasher können Sie mit opengazer beispielsweise mit Ihren Augen schreiben. Opengazer soll eine kostengünstige Software-Alternative zu kommerziellen hardwarebasierten Eye-Trackern sein.

Die erste Version von Opengazer wurde von PiotrZieliński entwickelt, unterstützt von Samsung und der Gatsby Charitable Foundation. Weitere Details zu dieser Version finden Sie hier.

Die Forschung für Opengazer wurde von Emli-Mari Nel wiederbelebt und wird nun von der Europäischen Kommission im Rahmen des AEGIS-Projekts und der Gatsby Charitable Foundation unterstützt.

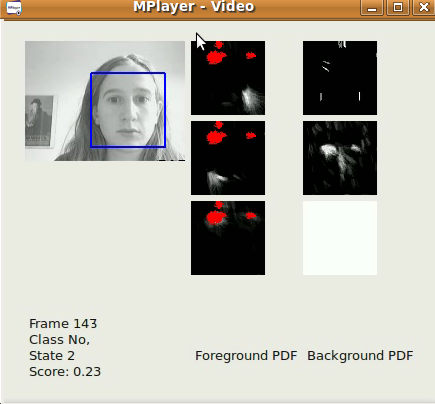

Die vorherige Version von Opengazer reagiert sehr empfindlich auf Kopfbewegungsschwankungen. Um dieses Problem zu beheben, konzentrieren wir uns derzeit auf Kopfverfolgungsalgorithmen, um Schwankungen der Kopfhaltung zu korrigieren, bevor wir auf die Blickpositionen schließen. Die gesamte Software ist in C ++ und Python geschrieben. Ein Beispielvideo eines unserer Head-Tracking-Algorithmen kann [hier] heruntergeladen werden. Unter Windows kann das Video mit dem VLC-Player angezeigt werden. Unter Linux wird es am besten mit Mplayer Movie Player angezeigt.

Die erste Version unseres Head-Tracking-Algorithmus ist eine elementare Version, die auf dem Viola-Jones-Gesichtsdetektor basiert und das größte Gesicht im Videostream (von einer Datei / Kamera aufgenommen) so schnell wie möglich Frame für Frame lokalisiert. Rahmenbasis. Die xy-Koordinaten aus dem Tracking können bereits für die Eingabe mit Dasher verwendet werden. Dies kann im 1D-Modus (z. B. durch Verfolgung nur der y-Koordinaten) oder im 2D-Modus erfolgen. Obwohl nach der Veröffentlichung unserer Head-Pose-Software viel bessere Ergebnisse zu erwarten sind, ist diese Software bereits für die schnelle Gesichtslokalisierung nützlich. Unser Algorithmus wendet einen einfachen autoregressiven Tiefpassfilter auf die xy-Koordinaten und den Maßstab der Erfassungsergebnisse des Viola-Jones-Gesichtsdetektors an und schränkt auch den interessierenden Bereich von Bild zu Bild ein. Die Erkennungsparameter wurden gemäß unserer spezifischen Anwendung bestimmt (d. H. Ein einzelner Benutzer, der an seinem Desktop-PC / Laptop arbeitet). Der Algorithmus eignet sich am besten für 320x240-Bilder mit einer Bildrate von 30 fps und angemessenen Lichtverhältnissen.

Ein Teilprojekt von Opengazer beinhaltet die automatische Erkennung von Gesichtsbewegungen, um ein switch-basiertes Programm zu steuern. Dieses Programm hat eine kurze Lernphase (unter 30 Sekunden) für jede Geste, nach der die Geste automatisch erkannt wird. Viele Patienten (z. B. Patienten mit Zerebralparese) haben unwillkürliche Kopfbewegungen, die während der Detektion falsch positive Ergebnisse hervorrufen können. Wir trainieren daher auch ein Hintergrundmodell, um mit unfreiwilligen Bewegungen umzugehen. Die gesamte Software ist in C ++ und Python geschrieben und steht demnächst zum Download zur Verfügung. Ein Beispielvideo unseres Gestenwechselalgorithmus kann [hier] heruntergeladen werden. Unter Windows kann das Video mit dem VLC-Player angezeigt werden. Unter Linux wird es am besten mit Mplayer Movie Player angezeigt. Beachten Sie, dass dieses Video Sound hat. Es wurden drei Gesten trainiert, um drei mögliche Schaltereignisse zu generieren: Ein linkes Lächeln, ein rechtes Lächeln und eine Augenbrauenbewegung nach oben entsprechen jeweils Schaltereignissen. In diesem Fall erkennt das Hintergrundmodell Blinzeln, plötzliche Änderungen der Beleuchtung und große Kopfbewegungen. Die erste offizielle Veröffentlichung wird Ende Juni 2012 sein.

Die erste Version von Opengazer hat den folgenden Workflow:

Feature Punktauswahl:

Während des Startvorgangs muss der Benutzer Feature-Punkte auf dem Gesicht mit der Maus auswählen. Diese Punkte werden in nachfolgenden Schritten im Algorithmus verfolgt. Die ersten beiden Punkte entsprechen den Augenwinkeln, die auch in nachfolgenden Schritten zum Extrahieren der Augenbilder verwendet werden. Der Benutzer muss den Kopf während des gesamten Vorgangs sehr ruhig halten. An diesem Punkt sollte der Benutzer vorzugsweise alle ausgewählten Merkmalspunkte speichern.

System kalibrieren:

Während dieses Schritts werden einige rote Punkte an verschiedenen Positionen auf dem Bildschirm angezeigt. Bilder der Augen werden während der Anzeige jedes Punktes extrahiert. Die Augenbilder und ihre entsprechenden Punktpositionen werden zum Trainieren eines Gaußschen Prozesses verwendet, der die Abbildung zwischen dem Bild eines Auges und der Position auf dem Bildschirm darstellt. Beachten Sie, dass bei Änderungen der Kopfhaltung häufig eine Neukalibrierung des Systems erforderlich ist.

Verfolgung:

Nachdem alle Kalibrierungspunkte verarbeitet wurden, liefert der Gauß-Prozess eine Vorhersageverteilung, so dass der erwartete Fokus des Auges auf dem Anzeigemonitor bei einem neuen Bild des Auges geschätzt werden kann. Wenn der Benutzer die ausgewählten Feature-Punkte lädt, wird der Viola Jones-Gesichtsdetektor einmal verwendet, um den Suchbereich zu bestimmen, in dem die Feature-Punkte erwartet werden. Anschließend wird der optische Fluss verwendet, um jeden Merkmalspunkt zu verfolgen. Die Augenbilder werden extrahiert (unter Verwendung der ersten beiden ausgewählten Eckpunkte als Referenz), und der Blick wird unter Verwendung der extrahierten Augenbilder und des trainierten Gaußschen Prozesses vorhergesagt.