Cảnh báo: trang này là bản dịch tự động (máy), trong trường hợp có bất kỳ nghi ngờ nào, vui lòng tham khảo tài liệu tiếng Anh gốc. Chúng tôi xin lỗi vì sự bất tiện này có thể gây ra.

Mở báo

Mở báo cáo

- Tên của công nghệ: Mở báo

- Liên kết: http://www.inference.phy.cam.ac.uk/opengazer/

- Giá bán: miễn phí

- Phổ biến: Quốc hội

- Yêu cầu vật lý tối thiểu: Bệnh nhân phải có thể di chuyển đầu một cách tự do.

Miêu tả cụ thể:

Opengazer là một ứng dụng mã nguồn mở sử dụng webcam thông thường để ước tính hướng nhìn của bạn. Thông tin này sau đó có thể được chuyển đến các ứng dụng khác. Ví dụ, được sử dụng cùng với Dasher, opengazer cho phép bạn viết bằng mắt. Opengazer nhằm mục đích trở thành một phần mềm thay thế giá rẻ cho máy theo dõi mắt dựa trên phần cứng thương mại.

Phiên bản đầu tiên của Opengazer được phát triển bởi PiotrZieliński, được hỗ trợ bởi Samsung và Quỹ từ thiện Gatsby. Chi tiết hơn về phiên bản này có thể được tìm thấy.

Nghiên cứu về Opengazer đã được Emli-Mari Nel hồi sinh và hiện được Ủy ban châu Âu hỗ trợ trong bối cảnh dự án AEGIS và Quỹ từ thiện Gatsby.

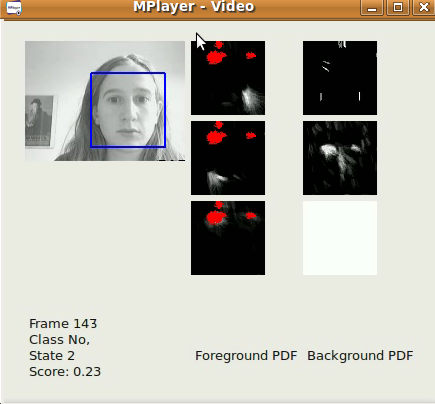

Phiên bản trước của Opengazer rất nhạy cảm với các biến thể chuyển động đầu. Để khắc phục vấn đề này, chúng tôi hiện đang tập trung vào các thuật toán theo dõi đầu để sửa lỗi cho các biến thể của tư thế đầu trước khi suy ra các vị trí nhìn. Tất cả các phần mềm được viết bằng C ++ và Python. Một video ví dụ về một trong những thuật toán theo dõi đầu của chúng tôi có thể được tải xuống [tại đây]. Trên Windows, video có thể được xem bằng trình phát VLC. Trên Linux, nó được hiển thị tốt nhất bằng Mplayer Movie Player.

Phiên bản đầu tiên của thuật toán theo dõi đầu của chúng tôi là phiên bản cơ bản, dựa trên trình phát hiện khuôn mặt Viola-Jones, định vị khuôn mặt lớn nhất trong luồng video (được chụp từ tệp / máy ảnh) càng nhanh càng tốt, trên khung hình-by- cơ sở khung. Các tọa độ xy từ theo dõi có thể đã được sử dụng để nhập bằng Dasher. Điều này có thể được thực hiện ở chế độ 1D (ví dụ: chỉ theo dõi tọa độ y) hoặc ở chế độ 2D. Mặc dù kết quả tốt hơn có thể được mong đợi sau khi phát hành phần mềm head-pose của chúng tôi, phần mềm này đã hữu ích cho việc bản địa hóa khuôn mặt nhanh. Thuật toán của chúng tôi áp dụng bộ lọc thông thấp tự động đơn giản trên tọa độ xy và tỷ lệ kết quả phát hiện từ trình phát hiện khuôn mặt Viola-Jones và cũng hạn chế vùng quan tâm từ khung này sang khung khác. Các tham số phát hiện đã được xác định theo ứng dụng cụ thể của chúng tôi (tức là, một người dùng duy nhất làm việc trên PC / máy tính để bàn của anh ấy / cô ấy). Thuật toán hoạt động tốt nhất trên hình ảnh 320x240, với tốc độ khung hình 30 khung hình / giây và điều kiện ánh sáng hợp lý.

Một tiểu dự án của Opengazer liên quan đến việc tự động phát hiện cử chỉ khuôn mặt để điều khiển chương trình dựa trên chuyển đổi. Chương trình này có giai đoạn học ngắn (dưới 30 giây) cho mỗi cử chỉ, sau đó cử chỉ được tự động phát hiện. Nhiều bệnh nhân (ví dụ, bệnh nhân bị bại não) có chuyển động đầu không tự nguyện có thể đưa ra dương tính giả trong quá trình phát hiện. Do đó, chúng tôi cũng đào tạo một mô hình nền tảng để đối phó với các chuyển động không tự nguyện. Tất cả phần mềm được viết bằng C ++ và Python và sẽ sớm được tải xuống. Một video ví dụ về thuật toán chuyển đổi cử chỉ của chúng tôi có thể được tải xuống [tại đây]. Trên Windows, video có thể được xem bằng trình phát VLC. Trên Linux, nó được hiển thị tốt nhất bằng Mplayer Movie Player. Lưu ý rằng video này có âm thanh. Ba cử chỉ đã được đào tạo để tạo ra ba sự kiện chuyển đổi có thể xảy ra: một nụ cười trái, nụ cười phải và chuyển động lông mày hướng lên trên tất cả tương ứng với các sự kiện chuyển đổi. Mô hình nền, trong trường hợp này, phát hiện chớp mắt, thay đổi ánh sáng đột ngột và chuyển động đầu lớn. Bản phát hành chính thức đầu tiên sẽ vào cuối tháng 6 năm 2012.

Phiên bản đầu tiên của Opengazer có quy trình làm việc sau:

Lựa chọn điểm đặc trưng:

Trong quá trình khởi động, người dùng dự kiến sẽ chọn các điểm đặc trưng trên khuôn mặt bằng chuột. Những điểm này được theo dõi trong các bước tiếp theo trong thuật toán. Hai điểm đầu tiên tương ứng với khóe mắt, cũng được sử dụng trong các bước tiếp theo để trích xuất hình ảnh mắt. Người dùng phải giữ cho đầu của mình yên tĩnh trong toàn bộ quy trình. Tại thời điểm này, người dùng tốt nhất nên lưu tất cả các điểm tính năng đã chọn.

Hiệu chỉnh hệ thống:

Trong bước này, một vài chấm đỏ được hiển thị ở các vị trí khác nhau trên màn hình. Hình ảnh của mắt được trích xuất trong màn hình của mỗi dấu chấm. Các hình ảnh mắt và vị trí chấm tương ứng của chúng được sử dụng để huấn luyện Quy trình Gaussian thể hiện ánh xạ giữa hình ảnh của mắt và vị trí trên màn hình. Lưu ý rằng những thay đổi trong tư thế đầu thường đòi hỏi hệ thống phải được hiệu chỉnh lại.

Theo dõi:

Sau khi tất cả các điểm hiệu chuẩn được xử lý, Quá trình Gaussian mang lại phân phối dự đoán, do đó, điểm tập trung mắt dự kiến trên màn hình hiển thị có thể được ước tính cho hình ảnh mới của mắt. Nếu người dùng tải các điểm tính năng đã chọn của mình, trình phát hiện khuôn mặt Viola Jones được sử dụng một lần để xác định vùng tìm kiếm nơi các điểm tính năng được mong đợi. Sau đó, dòng quang được sử dụng để theo dõi từng điểm tính năng. Các hình ảnh mắt được trích xuất (sử dụng hai điểm góc được chọn đầu tiên làm tham chiếu) và ánh mắt được dự đoán bằng hình ảnh mắt được trích xuất và Quy trình Gaussian được đào tạo.