警告:此页面是自动(机器)翻译,如有任何疑问,请参阅原始英文文档。不便之处,敬请原谅。

开盖泽

打开盖泽评论

- 技术名称: 开盖泽

- 链接: http://www.inference.phy.cam.ac.uk/opengazer/

- 价钱: 自由

- 人气: 不适用

- 最低物理要求: 病人必须能够自由移动头部。

详细说明:

Opengazer是一个开源应用程序,它使用普通的网络摄像头来估计您的视线方向。然后可以将该信息传递给其他应用程序。例如,与Dasher结合使用,opengazer可使您用眼睛书写。 Opengazer的目标是成为基于商业硬件的眼动仪的低成本软件替代品。

Opengazer的第一版由PiotrZieliński开发,并得到了三星和盖茨比慈善基金会的支持。可以找到有关此版本的更多详细信息。

Emga-Mari Nel恢复了对Opengazer的研究,现在在AEGIS项目和盖茨比慈善基金会的支持下得到了欧洲委员会的支持。

Opengazer的先前版本对头部运动变化非常敏感。为了纠正这个问题,我们目前集中在头部跟踪算法上,以在推断注视位置之前纠正头部姿势的变化。所有软件都是用C ++和Python编写的。 [我们的头部跟踪算法之一的示例视频可以下载[此处]。在Windows上,可以使用VLC播放器观看视频。在Linux上,最好使用Mplayer Movie Player进行显示。

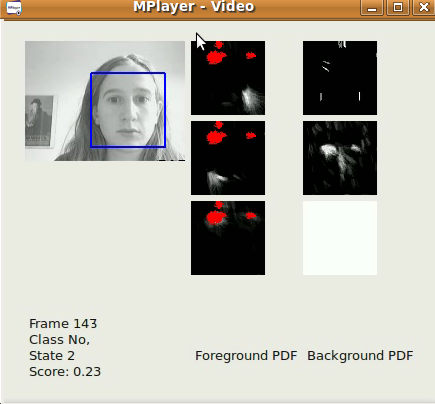

我们的头部跟踪算法的第一个版本是基于Viola-Jones面部检测器的基本算法,该算法可以逐帧快速定位视频流(从文件/相机捕获)中最大的面部,框架基础。跟踪的xy坐标已经可以使用Dasher进行键入。这可以在1D模式(例如,仅跟踪y坐标)或2D模式下完成。尽管发布我们的头枕软件后可以预期会有更好的结果,但是该软件已经可以用于快速的人脸定位。我们的算法对Viola-Jones面部检测器的检测结果的xy坐标和比例应用了一个简单的自回归低通滤波器,并且在帧与帧之间限制了感兴趣的区域。检测参数已根据我们的特定应用程序确定(即,一个用户在其台式机/笔记本电脑上工作)。该算法在320x240图像,30 fps帧速率和合理的照明条件下效果最佳。

Opengazer的一个子项目涉及自动检测面部手势,以驱动基于开关的程序。对于每个手势,此程序的学习阶段都很短(不到30秒),此后将自动检测手势。许多患者(例如脑瘫患者)会发生不自主的头部运动,从而在检测过程中可能导致假阳性。因此,我们还训练了一个背景模型来处理非自愿运动。所有软件都是用C ++和Python编写的,即将可供下载。可以在[此处]下载我们的手势切换算法的示例视频。在Windows上,可以使用VLC播放器观看视频。在Linux上,最好使用Mplayer Movie Player进行显示。请注意,该视频有声音。已经训练了三个手势来生成三个可能的切换事件:左微笑,右微笑和向上的眉毛移动都对应于切换事件。在这种情况下,背景模型可以检测到眨眼,灯光突然变化以及头部剧烈运动。首次正式发布时间为2012年6月。

Opengazer的第一个版本具有以下工作流程:

特征点选择:

在启动过程中,期望用户使用鼠标在面部上选择特征点。这些点将在算法的后续步骤中进行跟踪。前两个点对应于眼睛的角,在后续步骤中也用于提取眼睛图像。在整个过程中,使用者必须保持头部不动。此时,用户最好保存所有选定的特征点。

校准系统:

在此步骤中,屏幕上各个位置都会显示一些红点。在每个点的显示过程中提取眼睛的图像。眼睛图像及其相应的点位置用于训练高斯过程,该过程代表了眼睛图像与屏幕位置之间的映射。请注意,头部姿势的变化通常需要对系统进行重新校准。

追踪:

在处理完所有校准点之后,高斯过程会产生预测分布,因此,在给出新的眼睛图像的情况下,可以估计显示监视器上眼睛的预期焦点。如果用户加载了他/她选择的特征点,Viola Jones面部检测器将一次用于确定期望特征点的搜索区域。随后,使用光流来跟踪每个特征点。提取眼睛图像(使用前两个选定的角点作为参考),并使用提取的眼睛图像和经过训练的高斯过程预测凝视。