Attenzione: questa pagina è una traduzione automatica (automatica), in caso di dubbi fare riferimento al documento originale inglese. Ci scusiamo per l'inconveniente che ciò può causare.

Apri Gazer

Apri Gazer Review

- Nome della tecnologia: Apri Gazer

- link: http://www.inference.phy.cam.ac.uk/opengazer/

- Prezzo: gratuito

- Popolarità: NA

- Requisiti fisici minimi: Il paziente deve essere in grado di muovere la testa liberamente.

Descrizione dettagliata:

Opengazer è un'applicazione open source che utilizza una normale webcam per stimare la direzione del tuo sguardo. Queste informazioni possono quindi essere passate ad altre applicazioni. Ad esempio, utilizzato insieme a Dasher, l'opengazer ti consente di scrivere con gli occhi. Opengazer mira ad essere un'alternativa software a basso costo agli eye tracker commerciali basati su hardware.

La prima versione di Opengazer è stata sviluppata da PiotrZieliński, supportata da Samsung e dalla Fondazione di beneficenza Gatsby. Maggiori dettagli su questa versione sono disponibili.

La ricerca per Opengazer è stata ripresa da Emli-Mari Nel ed è ora supportata dalla Commissione Europea nel contesto del progetto AEGIS e della Fondazione di beneficenza Gatsby.

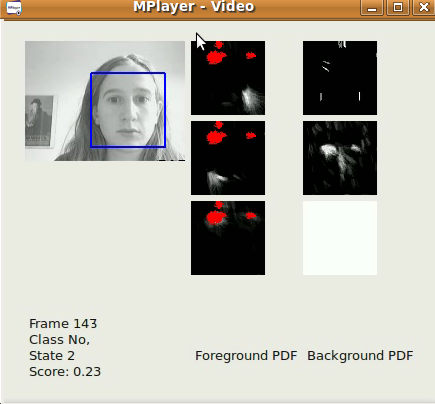

La versione precedente di Opengazer è molto sensibile alle variazioni del movimento della testa. Per correggere questo problema, ci stiamo attualmente concentrando sugli algoritmi di tracciamento della testa per correggere le variazioni della posa della testa prima di dedurre le posizioni dello sguardo. Tutto il software è scritto in C ++ e Python. Un video di esempio di uno dei nostri algoritmi di tracciamento della testa può essere scaricato [qui]. Su Windows il video può essere visualizzato con il lettore VLC. Su Linux viene visualizzato al meglio usando Mplayer Movie Player.

La prima versione del nostro algoritmo di tracciamento della testa è una elementare, basata sul rilevatore di volti Viola-Jones, che individua il viso più grande nel flusso video (catturato da un file / fotocamera) il più velocemente possibile, su un fotogramma per base del telaio. Le coordinate xy del tracciamento possono già essere usate per digitare usando Dasher. Questo può essere fatto in modalità 1D (ad es. Dal tracciamento solo delle coordinate y) o in modalità 2D. Sebbene dopo il rilascio del nostro software per la posa della testa ci si possano aspettare risultati molto migliori, questo software è già utile per una rapida localizzazione del viso. Il nostro algoritmo applica un semplice filtro passa-basso autoregressivo sulle coordinate xy e sulla scala dei risultati del rilevamento dal rilevatore di volti Viola-Jones e limita anche la regione di interesse da un fotogramma all'altro. I parametri di rilevamento sono stati determinati in base alla nostra specifica applicazione (ad esempio un singolo utente che lavora sul proprio PC desktop / laptop). L'algoritmo funziona meglio su immagini 320x240, con una frequenza dei fotogrammi di 30 fps e condizioni di illuminazione ragionevoli.

Un sottoprogetto di Opengazer prevede il rilevamento automatico dei gesti facciali per guidare un programma basato su switch. Questo programma prevede una breve fase di apprendimento (meno di 30 secondi) per ogni gesto, dopo di che il gesto viene rilevato automaticamente. Molti pazienti (ad es. Pazienti con paralisi cerebrale) presentano movimenti involontari della testa che possono introdurre falsi positivi durante il rilevamento. Pertanto, formiamo anche un modello di base per gestire i movimenti involontari. Tutto il software è scritto in C ++ e Python e sarà presto disponibile per il download. Un video di esempio del nostro algoritmo di commutazione dei gesti può essere scaricato [qui]. Su Windows il video può essere visualizzato con il lettore VLC. Su Linux viene visualizzato al meglio usando Mplayer Movie Player. Nota che questo video ha un suono. Sono stati addestrati tre gesti per generare tre possibili eventi di commutazione: un sorriso sinistro, un sorriso destro e il movimento delle sopracciglia verso l'alto corrispondono tutti agli eventi di commutazione. Il modello di sfondo, in questo caso, rileva battiti di ciglia, improvvisi cambiamenti di illuminazione e grandi movimenti della testa. La prima uscita ufficiale sarà alla fine di giugno 2012.

La prima versione di Opengazer ha il seguente flusso di lavoro:

Selezione del punto caratteristica:

Durante l'avvio ci si aspetta che l'utente selezioni i punti funzione sulla faccia usando il mouse. Questi punti vengono tracciati nei passaggi successivi dell'algoritmo. I primi due punti corrispondono agli angoli degli occhi, che vengono utilizzati anche nei passaggi successivi per estrarre le immagini degli occhi. L'utente deve mantenere la testa molto ferma durante l'intera procedura. A questo punto l'utente dovrebbe preferibilmente salvare tutti i punti funzione selezionati.

Calibrazione del sistema:

Durante questo passaggio vengono visualizzati alcuni punti rossi in varie posizioni sullo schermo. Le immagini degli occhi vengono estratte durante la visualizzazione di ciascun punto. Le immagini degli occhi e le rispettive posizioni dei punti corrispondenti vengono utilizzate per addestrare un processo gaussiano che rappresenta la mappatura tra l'immagine di un occhio e la posizione sullo schermo. Si noti che i cambiamenti nella posa della testa spesso richiedono la ricalibrazione del sistema.

tracking:

Dopo che tutti i punti di calibrazione sono stati elaborati, il processo gaussiano produce una distribuzione predittiva, in modo che il punto di messa a fuoco dell'occhio previsto sul monitor del display possa essere stimato in base a una nuova immagine dell'occhio. Se l'utente carica i punti funzione selezionati, il rilevatore di volti Viola Jones viene utilizzato una volta per determinare la regione di ricerca in cui sono previsti i punti funzione. Successivamente, il flusso ottico viene utilizzato per tracciare ciascun punto caratteristica. Le immagini dell'occhio vengono estratte (usando i primi due punti d'angolo selezionati come riferimento) e lo sguardo viene previsto usando le immagini dell'occhio estratte e il processo gaussiano addestrato.